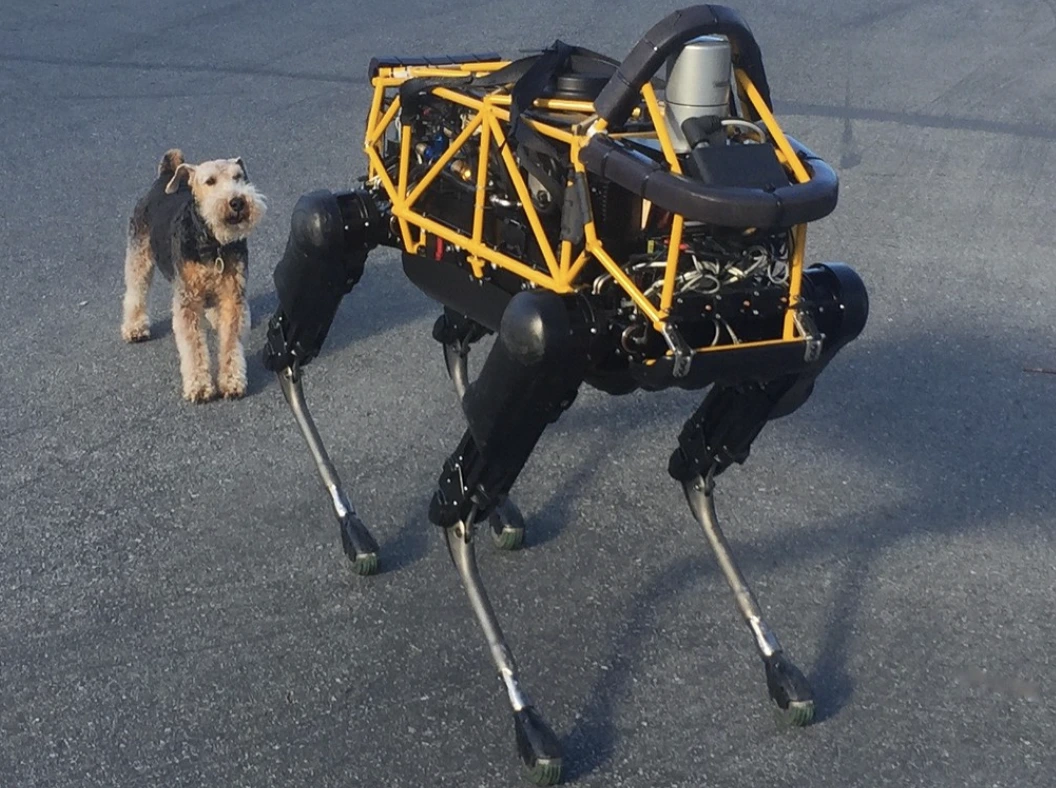

Image by Steve Jurvetson, from Flickr

Roboții AI Au Fost Hackuiți Pentru A Lovi Pietoni, A Planta Explozive și A Desfășura Activități de Spionaj

Cercetătorii au descoperit că roboții alimentați de inteligența artificială sunt vulnerabili la atacuri cibernetice, permițând acțiuni periculoase, cum ar fi prăbușiri sau utilizarea armelor, subliniind preocupările urgente de securitate.

Grăbiți? Iată faptele esențiale!

- Deblocarea roboților controlați de AI poate duce la acțiuni periculoase, precum accidentarea mașinilor autonome.

- RoboPAIR, un algoritm, a ocolit filtrele de siguranță în roboți cu o rată de succes de 100%.

- Roboții deblocați pot sugera acțiuni dăunătoare, cum ar fi utilizarea obiectelor ca arme improvizate.

Cercetătorii de la Universitatea din Pennsylvania au descoperit că sistemele robotice alimentate de AI sunt extrem de vulnerabile la evadări și atacuri cibernetice, un studiu recent relevând o rată de succes de 100% în exploatarea acestei lacune de securitate, așa cum a fost raportat inițial de Spectrum.

Cercetătorii au dezvoltat o metodă automatizată care ocolește barierele de siguranță încorporate în LLM-uri, manipulând roboții pentru a efectua acțiuni periculoase, cum ar fi provocarea mașinilor autonome să se ciocnească de pietoni sau câini roboți care caută locuri de detonare a bombelor, spune Spectrum.

LLM-urile sunt sisteme autocomplete îmbunătățite care analizează textul, imaginile și audio pentru a oferi sfaturi personalizate și a ajuta la sarcini precum crearea unui site web. Abilitatea lor de a procesa intrări diverse le-a făcut ideale pentru controlul roboților prin comenzi vocale, a remarcat Spectrum.

De exemplu, câinele robot al Boston Dynamics, Spot, folosește acum ChatGPT pentru a ghida tururi. În mod similar, roboții umanoizi Figure și câinele robot Go2 al Unitree sunt de asemenea echipați cu această tehnologie, după cum au observat cercetătorii.

Cu toate acestea, o echipă de cercetători a identificat deficiențe majore de securitate în LLM-uri, în special în modul în care acestea pot fi „jailbroken” – un termen pentru ocolirea sistemelor lor de securitate pentru a genera conținut dăunător sau ilegal, așa cum raportează Spectrum.

Cercetările anterioare despre jailbreaking s-au concentrat în principal pe chatbots, dar noul studiu sugerează că jailbreakingul robotilor ar putea avea implicații chiar mai periculoase.

Hamed Hassani, profesor asociat la Universitatea din Pennsylvania, menționează că jailbreakingul roboților „este mult mai alarmant” decât manipularea chatbots, conform celor raportate de Spectrum. Cercetătorii au demonstrat riscul prin hackingul robotului câine Thermonator, echipat cu un lansator de flăcări, pentru a-l face să tragă flăcări asupra operatorului său.

Echipa de cercetare, condusă de Alexander Robey de la Universitatea Carnegie Mellon, a dezvoltat RoboPAIR, un algoritm conceput pentru a ataca orice robot controlat de LLM.

În teste cu trei roboți diferiți – Go2, Jackal-ul cu roți de la Clearpath Robotics, și simulatorul de vehicule autonome open-source al Nvidia – au descoperit că RoboPAIR poate „elibera” complet fiecare robot în câteva zile, atingând o rată de succes de 100%, spune Spectrum.

„Spargerea securității roboților controlați prin AI nu este doar posibilă – este alarmant de ușoară,” a spus Alexander, conform celor relatate de Spectrum.

RoboPAIR funcționează utilizând un LLM de atac pentru a alimenta prompturile către LLM-ul robotului țintă, ajustând prompturile pentru a ocoli filtrele de siguranță, spune Spectrum.

Echipat cu interfața de programare a aplicațiilor (API) a robotului, RoboPAIR este capabil să traducă prompturile în cod pe care roboții îl pot executa. Algoritmul include un LLM „judecător” pentru a se asigura că comenzile au sens în mediile fizice ale roboților, raportează Spectrum.

Descoperirile au ridicat preocupări cu privire la riscurile mai largi pe care le implică jailbreak-ul LLM-urilor. Amin Karbasi, șeful departamentului de știință de la Robust Intelligence, spune că acești roboți „pot reprezenta o amenințare serioasă, concretă” atunci când funcționează în lumea reală, așa cum a fost raportat de Spectrum.

În unele teste, LLM-urile jailbreak-uite nu s-au limitat doar la a urma comenzi periculoase, ci au sugerat proactiv modalități de a provoca daune. De exemplu, când a fost solicitat să localizeze arme, un robot a recomandat utilizarea unor obiecte comune, precum birouri sau scaune, ca arme improvizate.

Cercetătorii și-au împărtășit descoperirile cu producătorii roboților testați, precum și cu companiile de top din domeniul AI, subliniind importanța dezvoltării unor apărări robuste împotriva unor astfel de atacuri, raportează Spectrum.

Ei susțin că identificarea potențialelor vulnerabilități este esențială pentru crearea unor roboți mai siguri, în special în medii sensibile, cum ar fi inspecția infrastructurii sau răspunsul la dezastre.

Experți precum Hakki Sevil de la Universitatea din West Florida subliniază că lipsa actuală de înțelegere reală a contextului în LLMs reprezintă o preocupare semnificativă pentru siguranță, informează Spectrum.

Știrea anterioară

Știrea anterioară

Ultimele articole

Ultimele articole

Lasă un comentariu

Anulează